Ce moteur de recherche p2p qui prétend etre contre la censure est encore une alternative qui ne fonctionne pas.

Des qu'on l'utilise, on commence de voir les problemes, problemes déjà mentionnés maintes et maintes fois dans les forums à ce sujet mais que jamais de nouvelle version ne vient régler, la seule mise à jour importante depuis des années est leur page de téléchargement ou les fonctions de dons d'argent ont été bien mise en avant et visible, alors que ça fait des années qu'ils ne mettent plus à jour ce moteur de recherche pleins de bugs et quasi inutilisable.

Il ne crawl meme pas les site en javascript, nombre de site visible sans probleme dans un navigateur semble censurer exprés yacy pour que les pages ne renvoient rien , j'ai ai déjà fait l'expérience.

Sur la homepage on peut voir qu'il est facile a installer sur diverses plateformes, et le probleme est bien là, il est facile à installer mais a utiliser, nettement moins...

Ce moteur de recherche en effet ne permet avec les réglages par défaut que de ne rien faire, il faut pour arriver à archiver plusieur milliers de pages l'autoriser à utiliser plusieurs gb de mémoire et là d'autres problemes arrivent.

Contrairement à ce qui est indiqué, impossible de faire crawler des milliers de pages par minutes, meme avec des dizaines de sites à crawler ça sera quelques centaines au maximum, il arrive de voir des pointes à quelques milliers mais c'est ultra rare et on ne sais pas pourquoi ni comment.

Souvent, yacy disparait, il faut le relancer, parfois meme ça ne se relance jamais, ça charge indéfiniment et il faut alors supprimer le dossier de l'index freeworld et recommencer ou charger une sauvegarde.

Dans la documentation ils prétendent que changer des réglages y changent quelquechose mais non, j'ai modifier tous les réglages que je pouvais, dans la config avancée, dans l'ini, mais non rien n'y fait. Meme avec 24gb de mémoire, yacy fini toujours par saturer la mémoire et l'interface déjà trés lente ne répond plus, meme en le laissant plus d'une journée ça ne répond plus jamais.

Quand on dépasse les quelques milliers de pages, ça devient impossible quasiment de bien fonctionner, les recherches sur mon index local ne donnent quasi jamais rien meme avec des millions de pages indiquées (+40millions), c'est ultra lent d'obtenir les résultats des autres yacy du réseau pourtant j'ai une bonne connexions de 300mb en fibre, le probleme n'est donc pas là du tout.

Ce moteur de recherche est une bonne idée mais tellement buggé et lent qu'il ne sert pas à grand chose.

Un probleme est que ça semble bien fonctionner et plus de pages ne sont crawlées, sans raison apparente, dans les logs ca m'indiquait que ça mettait des pages à charger, il n'a fait que ça pratiquement de toute la journée d'aprés les logs et en fin de journée ça m'indique que yacy est en mode junior, qu'il ne peut se connecter à d'autres pairs, là aussi sans raison ni explications de la cause.

J'ai fermé et redémarré et il est toujours indiqué en mode junior mais le crawl a repris , mais pour combien de temps ?!

Bref on dirait que chaque fonction est complétement buggée et aucun moyen de changer des options pour améliorer, rien n'y fait, quoi qu'on fasse ça finit toujours par ne plus fonctionner et il faut relancer pour que ça refonctionne quelques temps puis ça ne fonctionne plus de nouveau....

Je pensais avoir trouvé une version maintenant plus récente, https://github.com/smokingwheels/YaCy mais le probleme est que c'est encore pire, ça ne commence meme pas de charger quoi que ce soit, apparemment ça serait du au fait que ça fait comme si java n'était pas installé, pourtant j'ai essayé de relancer yacy aprés et ça se lance sans probleme, donc cette version prétend régler des problemes (je l'ai vu récemment sur le forum yacy) alors qu'en fait ça ne trouve meme pas java déjà installé sur le systeme, il y a différentes version de java fournies avec mais ça ne change rien du tout, l'un ou l'autre lien ne fonctionne pas ou ne fait rien.

J'ai quand meme essayé de voir le code source dans l'editeur Eclipse, voulant modifier quelques variables mais là aussi rien n'y fait, je télécharge le code source suivant plusieurs moyens à chaque fois un probleme, soit ça s'importe bien mais ça ne détecte pas Java quand je veux le lancer, j'ai essayé de modifier dans le systeme le parametre javacmd, le mettre dans la liste des variables des dossiers systeme, je vérifie avec cmd echo ça va, mais non rien n'y fait java n'est pas détecté.

Pire encore je vois que l'éditeur m'indique des milliers d'erreurs ?!

Je modifie quand meme les variables en compilant donc les fichiers changé avec l'installation depuis github dans eclipse et changer les fichiers compilés pour les remplacer dans mon installation de yacy qui fonctionne par les nouveaux modifiés.

Je voulais changer dans un fichier qui semble etre le nom de robot yacy, parce qu'en fait les variables dans la config avancée de yacy sur le nom du bot ne changent pas meme si on les change dans les parametres avancées, dans le fichier source il est indiqué que c'est pour les demandes de version personnalisée payantes, je modifie le code source, je compile, un fichier seulement a changé, dans la liste des fichier, un seul est du jour celui apparemment recompilé, je le met dans l'installation de yacy qui fonctionne, mais bien sur je relance yacy et rien ne change, le nom envoyé est toujours celui de yacy par defaut avec ma config systeme, version de navigateur,etc (je le vois dans un petit logiciel qui affiche les connexion sur l'ordi), donc c'est bien une variable qui est lancée durant l'utilisation...

C'est là que j'ai arrêté de m'intéresser à modifier ce logiciel, trop buggé.

Le pire est que lorsqu'on recherche, c'est apparemment fait a l'origine par un programmeur allemand diplomé officiellement !

---------------

J'ai essayé de relancer yacy avec une nouvelle installation, en mettant pour que le site ne soit crawlé qu'une fois par jour avec un maximum 100 ou 1000 pages, pour qu'il n'y ait que les nouvelles pages mais meme ça ne fonctionne pas, ça indique bien dans la liste des pages que le nombre de page pour ce domaine est dépassé, mais le probleme est que meme deux jours aprés, dans running crawl le domaine est toujours actif, ça indique toujours que le nombre de pages est dépassé comme configuré, mais le crawl ne s'arrête jamais, ça n'ajoute pas les pages dans yacy mais ça encombre et sature la mémoire et les ressources pour rien. On dirait que la moindre fonction de ce logiciel est buggé pour saturer la mémoire. Et là je ne suis meme pas a 2 millions de pages enregistrées et a peine plus d'une dizaine de "running crawls" (de sites différents à crawler en meme temps).

J'ai même essayé de le lancer en temps que service windows mais ça ne change rien du tout.

Bref, on se demande bien à quoi sert ce logiciel, qui est tellement buggé qu'il ne sert presque à rien.

--------------

Avril 2023

J'ai récemment voulu remettre yacy pour quand même laisser transférer les urls déjà crawlés à d'autres du réseau via la fonction de transmission des urls (dht) mais ça semble fonctionner relativement bien mais j'ai quand meme mis quelques sites à crawler avec peu de pages (max 1000 par exemple) pour ne pas surcharger d'urls en attente et que ça bloque le reste.

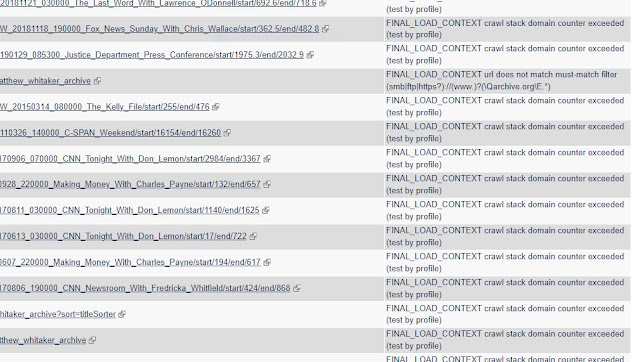

Et bien non, cette fois une nouvelle erreur est apparue pour plein d'urls de sites différent au début je pensais que c'était le nouveau site mais non, sur un autre site que j'ai crawlé peu souvent mais depuis longtemps la meme erreur apparait en meme temps, je soupçonne que là c'est pas yacy mais ceux abusant de technologies avancées qui me mettent une étrange erreur sur tous les fichiers non html (pdf, mp3, etc) qui peuvent être chargés, ça m'indique que le code est correct (200) mais que le corps du document n'a pas été chargé, donc la réponse est vide en fait...

J'ai ressayé quelques jours aprés, mais pareil, avec un autre site en plus ça fait pareil sur les fichiers non html (pdf, mp3,...), et ça recommence de bloquer au bout de 24h environ, le lendemain, c'est quoi cette fois, des abrutis avec technologie avancée qui se sont dit que yacy était comme une saison de 24h chrono, que ça devait durer que 24h ?!

--------------

J'ai quand même réessayé peu aprés avoir écrit ci dessus et bien sur changement, j'ai mentionné que ça plantait toutes les 24h environ et là curieusement ça remarche plus longtemps 2 jours environ mais la fonction de pourquoi je l'utilisais (transférer les résultats de recherche, la dht), a bloqué, au bout de 24h là environ, le lendemain, alors que ça a toujours bien marché cette fonction (on voit dans senturls et ça indique dans le log quand des résultats sont transférés), la ça ne fonctionne plus sans raison, durant des heures ça n'a rien transféré du tout sans raison et puis ça a buggé, yacy à surchargé apparemment (meme avec 20go de mémoire alloué presque que pour transférer et crawler deux trois sites a meme pas 100ppm).

Et j'ai réessayé pareil, aprés un peu moins de 24h, ça ne répond plus rien, et mieux encore je regarde dans le menu contextuel si il y a redémarrer, et bien non, et ça me fait comme si je cliquais sur arrêter et je vois yacy s'arrêter...

On me force même à arrêter yacy au bout d'un peu moins de 24h.

Et ils osent demander des dons sur paypal, github, patreon...

--------------

J'ai reessayé encore et encore et ça plantait quasi aprés le chargement, quelques minutes aprés, j'ai envoyé des logs d'erreurs chez java comme indiqué dans le log, mais aprés ça a marché quelques heures et de nouveau la même erreur. Mais je soupçone que ça soit des erreurs générées par des technologies avancées à distance qui en rajoutent au erreurs de ce programme.

Cette fois ils ont même allés jusqu'a déconnecté un instant mes disques externes ou il y a yacy et les sauvegardes de vidéos (deux disques différents sur port usb différent), ils se sont déconnectés en meme temps et reconnecté de suite, mais ça a fait planter le logiciel p2p qui refonctionnait normalement au bout de même pas une journée. Dès que quelques chose fonctionne bien, on me le supprime rapidement pour m'emmerder.

--------------

Les bugs ont encore changés avec ce logiciel, cette fois ça fonctionne pendant une semaine environ, et tout d'un coup l'interface ne répond plus, dans les logs ça semble fonctionner normalement, mais l'interface ne répond plus, la page n'indique rien, pas que il y a erreur, ça charge indéfiniment, j'ai laissé plusieurs heures la pages d'interface charger, mais rien, même aprés une nuit, ça charge sans indiquer aucune erreur ni quoi que ce soit...

--------------

Et j'ai relancé deux fois et pareil, le même problème mais maintenant ça ne dure meme pas 24h l'accés à l'interface, ça semble fonctionner normalement quand on lit les logs mais l'interface ne répond plus jamais.

--------------

Une nouveauté dans le harcélement, cette fois régulièrement, le nombre de page indiqué à crawler en attente se bloque plus ou moins longtemps sur un nombre qui contient le fameux 666, je l'ai remarqué depuis pas mal de temps, là depuis une heure ça ne crawl plus rien et c'est bloqué sur 710 666 pages en attentes...

Leur nouveau truc est de me bloquer au bout de quelques heures du réseau yacy, ca indique que mon installation yacy n'est pas visible pour les autres, on ne sait pas pourquoi, je ne change rien à la config, à l'ordi, à la connexion internet mais d'un moment à l'autre je ne suis plus "visible" pour les autres utilisateurs, on ne sait bien sur ni pourquoi ni comment !

Et pareil le lendemain, j'ai redémarré, ça remarchait et au bout de quelques heures ça refait pareil cette erreur là, de ne plus rien crawler sauf les rss, ils ont encore trouvé une nouvelle façon de m'ennuyer à reproduire des erreurs pareilles.

--------------

Je me suis souvenu qu'il y a déjà plusieurs années, j'avais essayé de commencé de faire un petit crawler, c'était pour faire un sitemap des sites au début mais j'ai a peine essayé de faire le premier essai de crawler qu'au bout de quelques dizaines de secondes, je vois une image comme sur l'écran de l'ordi comme d'un type militaire assis qui fait avec sa bouche le même mouvement que les poissons sortant de l'eau pour respirer, puis ça s'arrête et je n'ai jamais pu retoucher à ce programme, on m'en a empêché.

--------------

Un autre probleme de configuration est quand je change la valeur maximale de system load pour éviter la surcharge, puisque j'ai découvert qu'aprés quelques minutes, ou quelques temps, cette valeur rechangeait comme ça, sans intervention de ma part, et était de nouveau augmentée, je ne sais pas comment, si yacy est fait comme ça, par remote controle à l'insu de l'utilisateur, ou autre, quoi qu'il en soit on ne peut encore pas utiliser et configure yacy comme on veut qui là aussi semble donc fait pour surcharger.

Je baissais fortement cette valeur en mettant à 4 par exemple et aprés quelques temps quand je revérifais, elle était de nouveau augmentée, à 6 ou à 8 ...

Comme par "Magie" !

--------------

J'utilise la version derniere officielle release datant d'il y a quelques années et comme pour youtube-dl ils ont arrêté de faire des release officielles simples à installer et utiliser et donc c'est bien moins facile d'accés.

J'ai essayé de télécharger la version depuis github, mais bien sur contrairement à ce qui est indiqué ça ne fonctionne pas, je ne sais pas pourquoi, la fenetre de console se lance mais s'arrête aprés avoir indiqué quelques lignes qu'on a pas le temps de lire.

Pourtant sur la page github https://github.com/yacy/yacy_search_server#readme c'est indiqué ceci pour le lancer:

Start and stop it

Startup and shutdown:

Windows:

- Start by double-clicking

startYACY.bat - Stop by double-clicking

stopYACY.bat

- Start by double-clicking

Et même plus loin il est indiqué qu'on peut avoir des millions de pages dans l'index, hors d'aprés mon expérience, yacy est trés vite saturé et ne fonctionne pas bien du tout aprés quelques milliers de pages, pour fonctionner sans planter trés souvent, j'ai du rapidement aprés quelques millions de pages mettre plus de 20g de mémoire sinon ça indiquait tous le temps qu'il manquait de mémoire, yacy est présenté comme facile d'utilisation mais ça n'est pas du tout le cas et github laisse faire, c'est un programme ultra buggé qui ne fonctionne pas du tout aussi bien que prévu, mais ils laissent faire!

On nous bassine avec le moindre téléchargement dans le navigateur indiqué comme "dangereux", les addons maintenant sont si dangereux qu'on ne peut meme plus les installer sans passer par les vérifications de google et autre mais yacy buggé à mort sur github ça passe sans probleme, on voit bien qu'on fait tout ça pour se ficher des utilisateurs en réalité :

Scaling, RAM and disk space

You can have many millions web pages in your own search index. By default, 600MB RAM is available to the Java process. The GC process will free the memory once in a while. If you have less than 100000 pages you could try 200MB till you hit 1 million. Here you can adjust it. Several million web pages may use several GB of disk space, but you can adjust it here to fit your needs.

Bien sur, j'ai suivi aussi les instructions pour le compiler dans eclipe comme indiqué mais bien entendu, ça ne fonctionne pas, ça se compile, ça se lance, on voit l'icone de chargement de yacy normalement mais une journée plus tard ça indiquait toujours yacy en démarrage et l'interface 8090 ne répondait pas ....

[ Ils prétendent sur leur page officielle que c'est facile à installer et utiliser sur plusieurs OS mais en fait non, puisque les dernieres versions ne sont pas comme ça, il faut être un programmeur professionel apparemment pour pouvoir les utiliser, simplement les télécharger et même en suivant les instructions ça ne fonctionne pas ]

-----------------------

Un autre probleme intattendu indirecte, est que j'avais envoyé des logs à JAVA la société qui fait le systeme Java de yacy, et j'ai été informé que ces abrutis ayant reçus mes logs étaient allés porter plainte contre moi et que ce sont encore des services secrets qui ont appelés pour les arrêter, ces abrutis inventaient n'importe quoi alors que je n'avais fait qu'utiliser normalement le site pour les envois de bugs et en fait c'était leur formulaire qui tronquait les messages ne laissant que presque rien, que 800 caractères il me semble ...

Voilà le niveau actuel de médiocrité ou des sociétés en sont à porter plainte contre des utilisateurs pour rien du tout, simplement utiliser un formulaire comme il est prévu !

-----------------------

On trouve détranges erreurs avec Yacy est c'est là le gros probleme, bien souvent il n y a aucun moyen de savoir d'ou vient réellement le probleme, là Yacy ne se lance plus, ils tourne à vide on dirait durant des heures et des heures indiquant que ça démarre et dans les logs, ça semble charger plein de truc mais une erreur revient souvent, un probleme de mémoire, j'ai donc mis dans le fichier de lancement les mémoire a 10g (10000m) les deux de java indiqué dans le fichier de lancement mais non, ça ne change rien, windows indique que javaw le programme de yacy prend que dans les 600m comme indiqué par défaut mais que j'ai changé avant de le relancer, donc apparemment yacy ne prend meme pas en compte la mémoire indiqué dans le fichier de lancement !

Et l'erreur indiqué est étrange, puisqu'a chaque fois dans les logs ça indique avoir besoin de quelques mb de mémoire, indique une erreur outofmemory (manque de mémoire), alors que la mémoire indiqué libre sur la même ligne est bien supérieur à la quantité demandée, ici ~13Mb de demandé et 20Mb indiqué de libre... :

net.yacy.cora.util.SpaceExceededException: 13186820 bytes needed for RowCollection grow after OutOfMemoryError Java heap space: 20818168 free

Aprés avoir trouvé le probleme, c'est bien la mémoire allouée qui faisait défaut puisque aprés avoir regardé dans la config yacy.conf, tous les paramètres y compris la mémoire étaient revenu à defaut donc pas du tout assez de mémoire, là aussi c'est un probleme, pourquoi tout est revenu aux paramètres par defaut ?!

--------------------

Je l'ai donc relancé et les fonctions de transférer le crawl en partie sur d'autres instances refonctionnaient mais pas pour longtemps, au bout de quelques heures ça s'arrête sans raison, c'était pas du tout encore surchargé et même 24h aprés ça n'avait plus rien transféré, et tout est comme ça avec yacy on ne peut jamais vraiment savoir d'ou ça dysfonctionne et pourquoi. Changer les parametres n'y changent rien du tout.

Autre exemple, les outgoing connexions sont la liste des connexions que yacy utilise pour télécharger, les pages et autres, et donc c'est limité et ça aussi on ne peut le changer dans les parametres, dans la page des connexions, ça s'affiche et ça bloque toujours vers presque 280, moi à 278 en général.

Le probleme est que c'est pas que le téléchargement, quand je charge un sitemap de sitemaps, donc des millions d'urls, en fait ça télécharge bien les sitemaps, ajoute les urls à la liste des fichiers à télécharger mais ça semble rester dans la liste des connexions meme une fois le sitemap téléchargé puisque là avant quel'interface ne réponde plus comme il y a trop de fichiers en meme temps, ça indiquait déjà des dizaines de sitemaps de ce site, donc ça télécharge des dizaines de sitemaps du meme site au lieu de les télécharger progressivement et pire encore on dirait que ça utilise une connexion meme le sitemap chargé, et que ça libere le connexion qu'une fois le sitemap et les urls traitées par yacy, pas étonnant que ça bloque si facilement en effet, le temps que les milliers d'urls soient traités en fait, tout yacy bloque meme l'interface ne répond plus mais les logs fonctionnent, ça indique que ça ajoute des sitemap et crawl quelques urls par ci par là...

Et c'est long, là ca fait plus de 24h que ça ajoute des urls de ce site à crawler et que yacy est bloqué là dessus, pourtant il ne s'agit que dajouter les urls à la liste des urls à crawler, pas de les crawler et traiter !

------------------

C'est un bon exemple de "l'open source" et du libre tant vanté, résultat on a des tonnes de logiciels merdique qui ne fonctionne pas bien du tout, buggés, qui prétendent être libre alors qu'en fait ça ne fonctionne pas bien, c'est difficile à utiliser puisqu'il faut être un programmeur pro pour les utiliser puisqu'il faut bien souvent les compiler soi meme sur la machine qu'on veut utiliser, donc être un expert en programmation, bref, ça fait le contraire de la liberté tellement c'est difficile et compliqué à utiliser, ça fait que c'est réservé aux professionnels de la programmation.

J'ai déjà regardé sur github je cherchais les moteur de recherche comme ça mais je suis tombé sur plein de pages qui ne fonctionnaient pas, certains avaient aucun fichier, étaient pas mise à jours depuis des années et des années, un fatra de logiciels ou de pages de code quasiment inutilisables pour la plupart des gens.

Bref, encore un bon prétexte pour faire tout un tas de truc nuls à chier.

C'est comme avec java, censé permettre de faire un logiciel qui fonctionne sur toutes les plates formes prévues avec java, évitant de devoir faire plusieurs code sources différents et bien là j'ai installé java et donc malgré que java est installé, yacy ne trouve pas java quand je le lance et se ferme de suite aprés execution du fichier bat quand cest yacy avec le code source comme expliqué plus haut, avec ces logiciels libre ou open source, tout semble prétexte à ce que ça ne fonctionne pas, pourtant meme les indication de java dans le fichier de la source ou de la version avec programme d'installation sont les même donc ça devrait trouver java sans probleme.

---------------

J'ai depuis quelques semaines relancé yacy pour notemment essayer d'y inclure mes anciennes sauvegardes, mais c'est trés long puisque les fichiers font plusieurs giga et je voulais donc faire une seule sauvegarde finale complete de tout ce que j'avais déjà crawlé mais toujours le meme probleme, au bout de quelques heures, l'interface graphique ne répond plus mais dans les log on voit que ça semble continuer de crawler et importer la sauvegarde puis au bout d'un moment ça ne fonctionne plus pour x raison et on doit redémarrer et là j'ai redemarré hier voulant faire la sauvegarde complete ayant importé toutes mes ancienne sauvegarde, je vois que ça fonctionne et ce matin c'est indiqué que Yacy est en cours d'arrêt... A chaque utilisation il y a un nouveau probleme qui fait que ça bug et rend inutisable le logiciel.

Quand j'avais réussi de faire une ancienne sauvegarde de la base complete, pour 60millions d'urls environ, il a fallu plus de 48h au total, le fichier de backup augmentait petit à petit trés lentement...

J'ai essayé de le laisser comme ça pour qu'il transfert les résultat de recherche déjà effectués et les crawls à d'autres instances mais étrangement aprés quelques jours, il n'y avait plus qu'indiqué dans les logs que yacy rajoutait des éléments à transférer, que ça, jamais rien d'autre, et en fait il ne transférait jamais apparemment malgré la section de pairs et autre, il n'y avait plus aucun autre résultat dans les logs.

Il n'y a plus que des logs comme ça depuis des jours aucune autre info que selectpeers et extending chunks, jamais de transfer.

"I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: 9fN_dZ-mmZbJ:agent-keheheh-ufe-101/ score 1

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: 74hVtOE0JEFi:neonknight/ score 3

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: 8ubDT7ZCQfIa:roeschcc1/ score 2

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: 9fN_dZ-mmZbJ:agent-keheheh-ufe-101/ score 1

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: -9GlSgPg3Qtl:domokrada/ score 3

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: _tmfQ6m1LSdp:eskimo/ score 2

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: Cy8DBe665-h_:mifritscher/ score 1

I 2023/12/03 12:10:33 INDEX-TRANSFER-DISPATCHER extending chunk for peer -9GlSgPg3Qtl containing 1 references with 1 more entries

I 2023/12/03 12:10:33 INDEX-TRANSFER-DISPATCHER extending chunk for peer _tmfQ6m1LSdp containing 1 references with 1 more entries

I 2023/12/03 12:10:33 INDEX-TRANSFER-DISPATCHER extending chunk for peer Cy8DBe665-h_ containing 1 references with 1 more entries

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: Cy8DBe665-h_:mifritscher/ score 3

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: G-v3Dy_vqjBd:mrflibble/ score 2

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: KMFfar8waSHq:agent-naloneb-ufe-102/ score 1

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: G-v3Dy_vqjBd:mrflibble/ score 3

I 2023/12/03 12:10:33 DHT selectPeers/DHTorder: KMFfar8waSHq:agent-naloneb-ufe-102/ score 2"

J'ai relancé pour faire une sauvegarde et pareil, au bout de deux trois jours ça indique uniquement too many connexions in httpc pool et rien d'autre depuis au moins 24h, ça sature à chaque fois.

-----------------

J'ai installé la tout derniere version de yacy disponible officielle mais ça ne change rien, j'ai installé sur deux ordi différents et pareil, l'installation marche bien, c'est le probleme avec yacy, tant qu'on ne l'utilise pas mais qu'on se contente de l'installer et rien en fait ça marche trés bien. Le probleme fut quand j'ai voulu charger un dump de sauvegarde, le fichier semble se charger complétement vu la quantité de données transférées dans le repértoire yacy mais la sauvegarde ne se charge pas dans les données de yacy, le nombre d'url est a 0 et dans les logs en redémarrant on voit qu'il y a encore un probleme d'accés, une exception se lève et ça ne fonctionne toujours pas, et le probleme est encore le meme avec yacy, il n'y a pas moyen de savoir quel est réellement le probleme, meme charger une sauvegarde et ça bug sans message d'erreur, ça bug et et leve une exception et plus rien ne marche !

J'ai même essayé avec une installaton totalement vide, ça a correctement chargé le sitemap de plus de 200 000 urls mais je ne sais pas pourquoi elles sont toutes été mises dans les urls à crawler sur d'autres instances et aucune sur la mienne et pire encore, ça ne crawlait rien du tout, dans les logs toutes les urls indiquaient:

"NoticedURL shift from GLOBAL to LOCAL: double occurrence"

Je suis revenu à mon ancienne installation et alors que je pensais laisser pour transférer les résultats sur d'autres pairs maintenant une nouvelle erreur, ça indique -1 pour le port ssl alors que c'est normalement configuré par ailleurs, on me bloque donc le port sécurisé comme ça sans raison.

Ca à fonctionné pendant plusieurs jours sans probleme et ça redéconne, pas de probleme de mémoire, d'espace disque ou autre, rien d'anormal dans les logs mais ça redevient trés lent, rarement on voit quelques urls crawlés, mais on voit dans le prequeuing que c'est trés lent, environ une page traitée par seconde alors que l'ordinateur est pas surchargée, encore une fois impossible de savoir pourqoi ça rame, pourquoi c'est si lent.

---------------------

Je le laisse pour transférer la DHT sur d'autres pairs mais là aussi ça fini par bloquer, il y a des requetes get solr qui remplissent les connexions à Yacy, de la même IP et si je rajoute des connexions (250 au lieu de 200) ça marche quelques temps et ça sature encore, probleme, certaine connexions datent de quand j'ai lancé yacy il y a une semaine environ, elle ne sont pas supprimées automatiquement pour libérer, autrement dit une requete à yacy est infinie tant qu'elle n'est pas résolue, pas étonnant que ça sature à force !

---------------------

Il y a des sitemaps qui ne se chargent pas sans raison, pour deux sites et j'ai essayé sur un autre ordi avec une nouvelle installation de yacy sans aucun autre site, le problème est le même, le site map se charge dans yacy (on voit la commande get du sitemap) ça indique le site dans la liste des crawls et puis au bout d'un moment ça indique le crawl fini mais aucune page du site n'a été chargée, pourtant quand j'essaye avec le crawl normal du site, les pages sont chargées par Yacy et le site crawlé normalement, mais là passer par le sitemap et on dirait que ça fait comme si le sitemap était vide mais bien sur aucun message d'erreur particulier donc on ne sait pas pourquoi ça ne fonctionne pas.

---------------------

J'ai eu le probleme avec le fait que des pages peuvent etre crawlées par d'autres instances de yacy si on active l'option, le probleme est qu'on ne sait pas en fonction de quoi les pages sont crawlées par d'autres, souvent ça marche qu'avec les sitemaps et de plus, il y a indiqué le nombre de pages en attente de crawl sur d'autres instances, probleme, j'ai déjà eu le coup ou bien sur aucune page n'est crawlée en une journée, donc c'est en attente et si il n'y a pas de pages crawlées sur d'autres instances, aucun moyen de les remettre dans la file de l'instance locale.

---------------------

J'ai installé la toute derniere version pour tester et bien sur, premier probleme la sauvegarde ou dump de la base de donnée n'est pas importable n'étant pas la même version, et autre probleme que j'ai à chaque fois, au bout d'une journée environ, ça m'indique dans les logs qu'il y a un probleme pour inscrire l'index ou le hash de l'url dans la base de donnée, donc à partir d'un moment les urls sauvées ne sont plus enregistrées dans la base et même pour un probleme si important aucun message d'erreur à part dans les logs, en apparence tout va bien et en fait les urls ne sont plus sauvées correctement et enregistrées dans l'index !

----------------------

Autre exemple de contradiction avec Yacy, ça fonctionne avec Java censé faciliter le déploiment sur d'autres plates formes, on programme en java et donc le logiciel est normalement utilisable sur toute plateforme compatible Java (linux, windows, etc).

Probleme, là la derniere version windows date de 2020 et il y a d'autres packages pour les autres plates formes, qui sont plus récentes et bien sur la derniere version de développement n'a pas de programme d'installation alors ça ne fonctionne pas en réalité.

Pourquoi donc font ils ça, prétendre que c'est facile à installer et utiliser alors qu'il faut installer, que le programme est différent suivant les systeme alors que Java est censé éviter ça, le programme beta ne fonctionne pas parce qu'il n'y a pas de programme d'installation intégré, en plus les versions suivant les systeme d'exploitation sont différentes, pourquoi compliquer comme ça ?

Le programme ne semble pas détecter automatiquement si Java est déjà installé sur le systeme.

----------------------

Un des problemes est pour mettre à jour régulièrement les pages, par exemple j'ai essayé sur des sites publiant des articles tous les jours de les crawler avec une limite de 100 pages par jour maximum, ou meme de 10 toutes les quelques heures mais ça ne marche pas, au bout de plusieurs jours alors que l'on voit que l'action de crawler à été executée plusieurs fois, je n'ai toujours qu'une page du site dans l'index (?!), ou encore avec 100 pages, le crawl ne s'arrête pas donc le lendemain au bout de 24h la commande ne se relance pas étant déjà en train d'être executée, résultat depuis presque une semaine alors que c'est un site ayant des centaines de liens sur la homepage (agrégateur de nouvelles), je n'ai toujours qu'a peine plus de 100 pages crawlées...

----------------------

Autre exemple des graves bugs de Yacy, quand on programme un nouveau crawl de site, il y a des parametres à indiquer et des options et je me suis aperçu que mettre un depth au dessus de 8 ne sert à rien puisque de toute façon quand le crawl est lancé il y a un tableau des crawls en cours avec les parametres du crawl et c'est bien 8 qui est indiqué alors que je regarde encore dans la liste des actions enregistrées qui rouvre la page de config et là pourtant c'est bien par exemple 99 de depth qui est enregistré, de meme que il y a un parametre en dessous de depth illimité pour tel ou tel site (une expression régulière) et là aussi dans le tableau en cours d'execution c'est à chaque fois vide pourtant dans la page de config l'expression régulière est bien enregistrée...

----------------------

Yacy fonctionnait pas mal depuis plusieurs jours (ceux qui piratent yacy à distance étaient ils en vacances ?), mais là ça a recommencé, toujours de nouvelles erreurs, là j'ai lancé l'optimisation de la base lucène et ça a merdé bien évidemment, avec plusieurs dizaines de giga de libre sur le ssd, ça indiquait qu'il y avait des erreurs d'écriture, plus assez de place, etc j'ai du redémarrer, et là aprés des heures de démarrage (ça prend des heures à lire les index des blob des données, j'ai 800go environ et 80millions d'urls), ça s'est mis à indiquer tous le temps durant des heures en permanence des erreur de caractere html, j'ai encore du redémarrer et ça n'a pas fonctionné ça a bloqué pendant un jour avant que je redémarre (là ça redémarre), sur une ligne indiquant que ça lisait les crawl en cours et ça a bloqué donc là...

Ca marchait bien sans probleme durant des jours et là ça ne marche plus depuis des jours, on dirait qu'ils font une sorte d'équivalence de temps qui marche et ne marche pas !

-----------------

J'ai fini par redémarrer le lendemain c'était toujours bloqué sur cette ligne ou ça indique indexer un des fichiers de la base de donner divisé en 2go environ chacuns...

Je redémarre, ça démarre rapidement, en quelques dizaines de minutes et probleme au bout de quelques temps d'utilisation sans probleme, ça bloque au bout de meme pas quelques heures sur une ligne (dans le log ou dans la console débug), qui est celle indiquait indexer tel ou telle page ...

La j'ai redémarré depuis quelques heures et ça refait pareil, ça bloque sur le chargement dans les fichiers blob de 2go.

Comme on ne peut pas transférer la base sur une nouvelle installation plus récente à cause du changement de version de la base lucene, j'ai essayé une nouvelle installation mais là aussi dés qu'on commence de l'utiliser ça se met à sérieusement déconner, les crawls étaient indiqués quelques secondes et disparaissaient, le lendemain, j'ai laissé la nuit et apparemment ça chargeait les files d'attentes de quelques millions d'urls.

Donc en attendant que yacy mette des heures à charger quelques millions d'urls (les fichiers textes de urls à charger pas charger les pages elles meme depuis internet) on ne peut plus rien faire non plus.

Et ça redéconne bien sur, là le transfert de l'index sur les autres pairs ne se fait plus, dans la console début ça indiquait à chaque fois que le chunk était trop grand : 33 ...

Donc pour l'instant ça fait plus d'une semaine que je démarre et redémarre l'autre installation de yacy avec 80 millions d'urls crawlées et ça ne marche pas, donc c'est encore "perdu"!

Même donc la version la plus récente de linux est buggée comme ça, temps de chargement extrémement longs, bugs étrange bloqué sur 33, etc !

-------------

Le lendemain ça n'a toujours pas rechargé, ça a bloqué encore sur un des fichiers blob, il y en a beaucoup, la plupart passent sans probleme, ils sont tous environ de 2go et certains durent longtemps à traiter et d'autre ça bloque indéfiniment, sans aucune indication .

Deux heures que c'est bloqué maintenant sur une nouvelle erreur, ça indique deux fois de suite qu'un fichier blob est illisible et qu'il est supprimé, deux fois de suite le meme message exactement sur le meme fichier et depuis deux heure que c'est affiché sur la console de débug, plus rien...

-------------

Ca marchait relativement normalement depuis quelques temps et la on m'a piraté yacy puisque il recommençait d'indiquer des erreurs d'index, la page pour relancer la base de donnée ne marchait plus, aprés 2 ou 3 redémarrage ça a remarché mais l'index ne remarche pas et aprés ça ne charge plus yacy parce que plein de fichiers indiquent des erreurs de lecture au démarrage.

J'ai réussi à installer la dernière version et pareil, les sites dits alternatifs comme décrit ci dessous indique une erreur 429 trop de requêtes au bout de quelques centaines de pages crawlees...

----------------------------------

Toujours aucune amélioration, j'ai installé la dernière version dite de linux mais comme c'est java ca marche sur Windows, la j'ai installé sur win11, avec openjdk, plus de 20g de mémoire, et pareil au bout de deux trois jours et même pas 1millions de pages, yacy plante et le log indique une erreur out of memory...

Dans les logs pire encore ça indique un problème d'allocation pour l'index ou il faudrait 100mb et sur les en fait 25go alloué à yacy il ne trouve pas 100mb de libre ..

----------------

On voit bien que ce programme est fait pour bugger, il y a régulièrement une erreur d'un champ process_sxt qui n'est pas active et ça bloqué tout.

Et les mêmes erreurs que la version 2020 reviennent malgré que je l'utilise sur un ordi bien plus puissant il n'y a pas de ralentissement et pourtant encore une erreur java quand j'essaie d'afficher certaines pages depuis l'interface...

J'ai relancé et que des nuisances, ça ne charge que 2000 pages d'un site qui en a bien plus et ça ne charge plus les autres sites .

Encore une nouvelle avec la dernière version fin juillet 2024, la liste des gros à crawler sur d'autres pairs se met à 0 , quand je relance plus aucune url nest a crawler sur d'autres pairs alors que l'option est activée.

Ça continue de bugger sans raison, ca switche de mode senior à junior toutes les quelques heures sans que je ne change rien à la config de quoi que ce soit, l'ordi, yacy, la box.

Je lance avec start debug qui affiche la console des logs, en arrêtant ça indique l'arrêt des threads , l'interface de yacy ne répond plus mais ça continue de charger les urls d'un rss.

La ça indique que deux fichiers blog sont fusionnés en un et plus rien depuis une heure.

Encore un nouveau dysfonctionnement, cette fois ça se met coupé du réseau que en local dans les logs ça indique mode Robinson on ....

Cette fois ça recommence, mode Robinson on donc aucune connexion, les pages renvoient toutes une erreur hors délais, le partage de la dht ne fonctionne plus.

Tout ce indique la console log, est depuis des heures noticed url shift from global to local double occurrence, ce sont des doublons d urls , retirés de la liste a crawler des urls locales et sur d'autres instances. Problème donc , pendant ce temps long yacy est coupé de tout réseau, et vu la vitesse ou ça va , quelques dizaines durls à la seconde de traitées sur des millions ça va être long.

Il y a quand même l'indication dans les logs d'un numéro étant le nombre de pages qui reste à traiter, et donc en plus de deux jours il n'y a que la moitié environ des urls de la liste qui ont été traitées puisque ce ne sont que des urls même pas des pages et il y en avait que moins d'un million.

Donc pour supprimer de la liste des urls à crawler parce que en doublons quelques centaines de milliers de ces urls, yacy bloque tout et met une semaine.

La liste corecrawljobsize est arrivée à 0 au bout d'une semaine mais l'autre de plus de 10 millions est loin d'être vide, à ce rythme il faudra des semaines....

Ça n'était pas arrivé depuis le changement d'ordinateur mais yacy à de nouveau disparu comme ça, le programme s'arrête sans raison.

----------

Durant plusieurs jours ça à bloqué sur le prequeuing au maximum sans raison ni indications, j ai du redémarrer et ça à recommencé et il y a encore eu des erreurs d'allocation mémoire et plus rien ne fonctionne alors qu il y a bien assez de mémoire libre.

-------------

Il y a un sérieux problème quand il y a beaucoup de domaines, c'est la qu il y a toujours l'erreur d'allocation de memoire meme si le systeme en a bien assez, ça ne semble pas prévu pour des dizaines de milliers de domaines différents en attente dans local crawling.

Quand je crawl un site de pages persos avec plein de sous domaines, comme xyz.domain.com quand ça atteint des dizaines de milliers de sous domaines à crawler, l'erreur de mémoire de la table d'index se produit à chaque fois.

-------------

Nouvelle variante, maintenant des le démarrage ça sature la mémoire, ça utilise toute la mémoire allouée possible, la 30go, et on ne sait pas pourquoi non plus.

-------------

J'ai essayé de remettre un dump d'une ancienne sauvegarde mais la aussi ça ne fonctionne pas. J'ai essayé de mettre sur plusieurs installations mais à chaque fois ça semble charger et ça fini par indiquer aucune page dans l'index et ça met un message d'erreur intitulé oops et un message d'erreur java quand je veux afficher une page de yacy dans le navigateur.

------------

De nouveaux problèmes, maintenant au bout de quelques minutes ça indique connexion pool closed et on ne sait pas pourquoi.

Je dois redémarrer plusieurs fois et il y a toujours quelque chose qui deconne, le transfert de la dht ne fonctionne pas où le crawl sur d'autres instances.

Ça a recommence de vider lentement la liste des urls à crawler j'ai clique sur terminate all au bout de 3 jours et tout à été vide directement mais j'ai du redémarrer et le transfert dht ne fonctionne pas, mais le crawl sur d'autres instances fonctionne...

Une nouvelle erreur maintenant ça indique que il y a une erreur de bookmark pour je ne sais quel hash durl.

-----------------

La fonction de limiter le nombre de pages ne fonctionne toujours pas bien, la limite était atteinte et le lendemain ça continuait d ajouter des urls à crawler...

-------------

Une fonction de charger les rss qui fonctionnait bien, ne fonctionne plus ca indique une page d'erreur java à la place. Yacy est fait comme pour tomber en ruine, la moindre fonction qui marche fini par ne plus fonctionner.

-------------

Cette fois depuis quelques jours ça ne fait que transférer la dht, sauf rarement une mention que deux fichiers blob de l'index sont fusionnés...

Il y a l'indication régulièrement que transférer quelques kb est trop, ce programme est configuré pour indiquer que même pas un méga de la dht à transférer ça fait trop !

Deux fois que je relance et des que je regarde la console, ça me met un instant la liste de urls ajoutées d'un rss et ça va ou en est maintenant l'affichage de la console bien après ça et ça bloque , les urls ne sont plus chargées et que la dht est transférée.

Ça semble refonctionner mais ça indiquait que le cache était plein, et ce n'est qu'après avoir fait autre chose que des que je regarde pour réduire la quantité du cache que tout bloque, l'interface ne répond plus et la console est bloquée.

------------

Encore une nouvelle, cette fois yacy est bloqué et la console affiche en boucle blobheap nomdefichier.blob too long size xxxxxxxx at yyyyyyyyyyy

Le fichier était un fichier cache donc au lieu de ne plus l'utiliser, yacy bloque tout, j'ai du supprimer le fichier.

J'ai supprimé le cache et ca ne change rien aux performances, mais au bout de deux trois jours ca a indiqué que ca fusionnait deux fichiers blob, ca a tout bloqué sauf le crawl sur d'autres instances et cest comme ca depuis hier....

------------

Suite a un enieme redémarrage ca fonctionne et ca se remet en mode robinson, ca bloque les connexions, vide les urls en attente de limit crawler et apres une nuit c'est toujours bloqué, ca indique que ca attend pour un site et un message complique de solr qui log update factory et d'autres chiffres incomprehensibles et ca en permanence depuis des heures.

Ces problemes existent depuis la version 2020 et dans les derniers changelog recents que des corrections superficielles du style les urls seront en https par défauts...

Depuis quelques jours ca ne fait que vider les urls de local crawler, il n'y a plus aucune connexion exterieure, mais ca ajoute en fait un hash d'url aux documents locaux. Ca ajoute donc des hash durls depuis un fichier local et ca vide la liste normale des urls a crawler. Mais cest lent parce que ca passe quand meme par les crawls delay des sites , ca indique le temps d'attente comme si ca passait par le site internet...

Maintenant au bout de quelques heures ca indique des erreurs de manque de memoire et ça fini toujours par indiquer connection pool closed alors que l'ordi est loin d'étre saturé.

Autre bug, ça indique que des fichiers sont trop grand pour le cache alors qu'ils font 20 mo et que j'ai mis la taille des fichiers maximale a crawler a presque 1go, 950mo.

A chaque fois au bout de quelques heures ca se met a faire des erreurs java heap space et indiquer que l'index writer is closed alors que rien ne semble surchargé.

----------

Ca fonctionnait depuis deux trois jours et une nouvelle erreur, des termes dans des pages sont trop longs et ne peuvent etre inséré dans la base de données solr...

Et quelques heures plus tard, tout se bloque avec l'erreur out of memory de java heap sans qu'on sache pourquoi.

Yacy est visiblement piraté pour cesser de fonctionner au bout de 3 jours, encore une fois ca indique index writer closed et ca fini par indiquer connexion pool shutdown...

En plus des bugs de yacy il est piraté quand il fonctionne pour le bloquer.

A chaque fois que j'ai redémarré, la fonction de partager la dht ne fonctionne qu'une fois sur deux alors que je ne change aucune options.

Le statut change sans raison passe de senior à junior et inversement tout au long de l'utilisation même après redemarrage et ca sans raison, mes options et ma connexion ne subissent pas de changement.

-------------

Toujours de nouvelles erreurs, cette fois au bout de deux trois jours, ca n'indique plus que selectedcontainercache was filled with x entries et splitcontainercache enqueued to write the buffer array wich has now 0 entries.

-----------

Je vais pas continuer à m emmerder a détailler les bugs de yacy vous avez compris le principe.

Par contre je note les nouveautés, j'ai crawle wordpress et depuis quelques temps plus aucun site wordpress ne passe, je decouvre que wordpress.com est dans ma blacklist, et dans la liste des sites opensearch heuristique il n y a plus que des sites wordpress.com .

----------

Quand j'ai installé yacy sur un ordi plus puissant, j'ai eu de suite même avec peu de résultats des erreurs comme si ca manquait de mémoire et ce sont des daubos qui utilisent le remote control pour la essayer de me forcer à racheter de la memoire, ils ont même essayé de me faire me dire que yacy marcherait mieux comme si ca allait regler le problème.

Un taré a même essayé de me faire lui donner tout mon argent faisant croire qu il serait bien placé et il a fait comme si c'était un don pour yacy et j'ai été ruiné.

---------

Ils prétendent que c'est non censurable mais ils utilisent le remote control pour faire bugger yacy et l'empêcher de fonctionner normalement.

De même qu'un taré de programmeur principal de yacy à demandé à ce que je sois interpellé au début de la rédaction de cet article, c'est dire à quel point ils pètent plus haut que leur cul

------------

Ca allait relativement bien et ça s'est mis à afficher un message d'erreur java qui defile si vite qu'on ne peut rien lire et le crawl sur d'autres instances ne fonctionnait plus.

-------------

Il y a dans yacy une fonction qui augmente le crawl delay artificiellement au dela de 10000 urls, il est rallongé de façon arbitraire sans logique.

J'ai mis ça en commentaire sous une vidéo youtube de yacy et il a vite disparu je ne le retrouve pas sauf erreur.

https://github.com/yacy/yacy_search_server/blob/master/source/net/yacy/crawler/data/Latency.java

* Used by crawler to calculate additional access delay time for often accessed hosts

* (access count > 10000 returns half of the range parameter) linear incrementet from 0 up to (range div 2)

* @param range the current delay time

* @return the additional delay in ms (max: range div 2)

*/

public int flux(final int range) {

return this.count.get() >= 10000 ? range >> 1 : (range * this.count.get() / 10000) >> 1;

}

-------

J'ai essayé de rouvrir la derniere version de yacy dans eclipse en faisant un projet depuis un téléchargement de github, pas de problème jusqu'au téléchargement d'un composant ivy je crois de chez apache depuis l installateur de packages puisqu'il y a bien ce package liste mais le lien indiqué ne fonctionne pas bien sûr.

Et toujours les 4000 erreurs indiquées.

----------

Encore une nouvelle, je vais à l'ordi et regarde yacy et il y a un mot de passe mis en localhost donc je n'ai plus acces a l'administration...

----------

J'ai essayé de réinstaller et bien sur le dump ne va pas, ca fait planter yacy des le démarrage, a chaque fois que j'ai voulu utiliser un dump de memoire ca n'a jamais marché ca fait bugger à chaque fois.

On est début 2025, je n'avais pas utilisé yacy depuis des semaines et pareil, au bout de quelques dizaines de pages ca indique too many requests sur bitchute, avec archive.org les flux advanced search ne sont pas triés selon les options demandées par date pour avoir les plus recents...

Les sites qui ne fonctionne pas exprès avec Yacy

Cette liste de site contient des sites qui ont fonctionnés avec yacy mais qui ont cessé de permettre à Yacy de les crawler, j'ai bien sur essayé plusieurs fois en plusieurs semaines ou mois d'intervalle de les crawler, mais ils font exprés de ne pas permettre à yacy de les crawler sans raison, la page ne renvoie rien alors que le site fonctionne quand même trés bien sur navigateur classique.

J'ai encore certains de ces sites avec des urls dans la base de données des sites crawlés de yacy mais ils ne fonctionnent plus donc avec yacy mai ntenant. Je ne sais pas ou est le blocage, du propriétaire, de l'hebergeur, etc.

Beaucoup sont des petits sites ou dits alternatifs, certains banni des grand sites comme youtube mais qui se permettent comme brighteon de bannir les crawler p2p non censurables comme Yacy, tout en se plaignant d'être censuré de partout quand il s'agit de faire leur promotion pour récolter des dons (voir ma page d'articles taggé alternatifs pour plus d'infos: https://abus-commerce.blogspot.com/search/label/Alternatif ).

- BitChute

- Brighteon

- ArianeBilheran

- Artivision

- Agoravox

- Fawkes-news

- Wikiwix (Archivage)

- 4chan

- Archive.is

- www.newstarget.com : Ce sont les sites du groupe naturalnews qui se targue de liberté mais ne permettent meme pas à un moteur decentralisé non censurable de crawler leurs sites, ils ont plein de sites thématiques en .news que là aussi, j'ai pu crawler au début mais maintenant Yacy est bloqué. Il y en a sur la page https://www.naturalnews.com/ : https://www.food.news/ ; https://www.censoredscience.com/ ; https://www.health.news/ ; https://www.cancer.news/ ...

[ Mise à jour: des mois aprés avoir écrit ça, j'ai vu que ça remarchait mais pareil au bout de quelques jours de crawl ils ont bloqué apparemment puisque pour yacy ça renvoyait rien du tout et sur le même ordinateur ça ouvrait dans un browser classique la page du site newtarget sans probleme, ils recommencent donc de faire exprés que ça en fonctionne pas avec yacy... voilà à quoi s'occupent ces alternatifs !]

- dailymotion

- altcensored.com , j'ai réessayé des mois plus tard et pareil, ils renvoient un code d'erreur comme quoi ça fait trop, même de crawler le rss une fois par jour et ils renvoient le code que ca fait trop.

- abovetopsecret.com

- beforeitsnews.com

- sott.net

- worldtruth.tv

- reporterre.net

- brandnewtube.com

- Youtube / Dailymotion : Durant des mois ça fonctionnait bien, mais ils ont changé leur site pour que le navigateur qui n'a pas javascript ne puisse rien voir du site

- framatube.org : Et les sites utilisant framatube comme logiciel de site, n'a jamais fonctionné malgré prétendant être alternatif, il faut un navigateur moderne des grosses société pour l'utiliser

- https://alternativeto.net/

- http://www.archive.org/ Ce fameux site prétentieux qui prétend archiver internet pour que ça reste accessible est en réalité un leurre, récemment ils ont empêché yacy de crawler leur site, plus rien ne s'affiche avec yacy a part le titre ... En réalité ils rendent inacessible internet.

- https://oldergeeks.com/ Ce petit site marchait bien, et je me suis aperçu que là aussi yacy a été bloqué, j'ai encore des milliers de pages du site mais maintenant c'est bloqué, la page renvoyée à yacy est vide.

- Reddit : le célèbre site de forum à en effet peu aprés que j'ai commencer de crawler le site avec les sitemaps du site donc fait pour ça ont simplement supprimé leurs sitemaps, et oui, ils font vu que je crawlais avec yacy et les sitesmaps meme des mois aprés étaient toujours supprimés, ça indiquait une erreur comme si les sitemaps n'existaient pas ! La prochaine étape est de supprimer les forums du site peut être ?!

- mail-archive.com : le site fonctionnait bien depuis longtemps et d'un jour a l'autre plus de sitemaps, et le site avait des millions de messages et ca semble revenu a 0 puis ca augmente petit a petit, la ca indiquait même pas un million de messages sauvés.

- https://fossies.org/ a bloqué yacy interdisant yacy par le fichier robots.txt

-------------

Cet article a été ecrit en plusieurs fois durant des années et certains problèmes d'impossibilité de crawl de site sont du a des blocages parce que des abrutis portent plainte d'avoir crawlé leur site comme ca sans raison et sont donc des procéduriers qui se prétendent alternatifs, rejetés et portent plainte contre le fonctionnement d'Internet comme oldergeeks ou altcensored ou bitchute.

D'autres sont des tarés ou tarėes qui m espionnent et qui portent plainte de voir que je crawl tel ou tel site et obtiennent le blocage comme ça sans aucune raison.

---------

J'ai essayé la version yacy_v1.940_202412022212_3ede322f5.tar.gz et pareil, a chaque fichier importé de l'ancien index en xml.gz une erreur et il faut redémarrer solr et au bout de quelques fichiers importés une erreur de mémoire opération unsafe et plus rien ne fonctionne même en redémarrant yacy.

J'ai essayé encore, il fallait redémarrer la base solr souvent à cause d'erreurs et il y a eu une erreur dans un fichier et après un scandisk yacy plante au démarrage.

Nouvelle installation après quelques instants d'import d un fichier xml de backup ça indique une erreur dans un tableau trop grand...

J'ai réinstallé sans backup et ça semble fonctionner mais au bout de un ou deux jours des sites bloquent, archive.org retourne une erreur quand yacy charge des rss, neocities.org pareil bloque le chargement ou bitchute bloque pareil la connexion, oocities pareil bloque en renvoyant un délais trop grand. Ils font visiblement exprès d'empêcher le fonctionnement normal prévu d internet.

Yacy n'a pas bloqué au bout de plus d'une semaine mais j'ai du redémarrer et une erreur dans un fichier .pos de 0ko plante le chargement.

J'ai essayé une nouvelle installation et la sauvegarde que j'avais déjà faite de la première installation ne fonctionne pas bien sûr, une erreur indiquée lors de l'importation et yacy ne démarre même plus.

Essai suivant, yacy est bloqué depuis la veille d'après le log sur l'enregistrement d'un fichier cache et ça ne demarre plus indiquant une erreur dans un fichier alors que scandisk indique aucune erreur...

Cette derniere version est la pire.

Nouveau bug, un fichier xml.gz pose problème et génère une erreur qui défile en permanence, comme le fichier est ouvert par yacy pour l'importer depuis surrogates in, je ne peux pas l'enlever du dossier et comme l'import est automatique je dois fermer yacy pour pouvoir l'enlever du dossier d'import.

Les rss d'archive.org ont fonctionnes de nouveau une fois puis ont été bloqués que pour yacy, le rss est invalide que pour yacy dans le navigateur ça s'affiche normalement.

------

Après moult essais cette version bug systématiquement au bout de quelques jours, souvent une erreur qui concerne la base de données, une erreur qui défile en permanence d'unsafe memory opération.

-------

Juillet 2025 et un message sur le forum montre une erreur de débutant lors de l'écriture de la base de données ça ne vérifie pas si la variable est nulle ou vide...

Dans la correction nouvelle erreur une variable est déclarée à chaque itération de la boucle ce qui ralenti énormément le programme.

https://github.com/yacy/yacy_search_server/issues/717

http://web.archive.org/web/20250710124928/https://github.com/yacy/yacy_search_server/issues/717

J'ai demandé à une ia d'améliorer cette fonction et c'est intéressant mais je n'ai pas le code a copier la. Ça conseillait d'utiliser stringbuilder et de ne pas utiliser write tout de suite a chaque fois mais de copier dans une variable et d'écrire en une fois.

-----

Cette version de 2024 est la plus récente en juillet 2025, ils ne font même pas de nouvelle version.

-----

Rien ne fonctionne, sur cette page est indiqué une méthode pour compiler yacy https://github.com/yacy/yacy_search_server?tab=readme-ov-file#help-develop-yacy et sur celle ci une autre plus récente: https://hub.docker.com/r/yacy/yacy_search_server#help-develop-yacy

J'ai essayé la seconde et une erreur étrange de fichier non trouvé build.xml mal décrite. Je veux cloner la dernière version de github et il faut un mot de passe maintenant ...

On est toujours emmerdé dès qu'on fait quoi que ce soit avec ce programme.

MAJ: J'ai réessayé de l'ouvrir dans eclipse et dans la liste des fichiers du projet le fichier build.xml est nommé porn.xml ...

Voilà à quoi s'occupent des abrutis à me pirater pour renommer des fichiers comme ça.

------

Il y a des groupes qui sont assignés à emmerder les utilisateurs de yacy qui piratent les connections, je les vois derriere leurs ordis mais je ne sais pas qui c'est ni pour qui ils travaillent.

--------

Exemple, un sitemap de 60 millions d'urls met plus d'un an à être crawlė puisque en une semaine c'est même pas un millions d'urls que yacy crawl, ayant essayé avec les sitemaps du site https://mail-archive.com/robots.txt .

------

Novembre 2025 et un message sur github montre que le problème est encore pas réglé https://github.com/yacy/yacy_search_server/issues/740

Toujours ce problème malgré des années, des ordis plus performants, de vitesse de crawl, on dirait que yacy est configuré pour considérer tous les sites à crawler comme un seul site vu les performances globales qui sont comme pour un seul site.

Aucun commentaire:

Enregistrer un commentaire